東京工業大学と富士通などは10日、スーパーコンピューターの「富岳(ふがく)」を使って生成AI(人工知能)の基盤技術を開発したと発表した。AI向け半導体の供給を一手に握る米エヌビディアの製品を使わず、富士通のCPU(中央演算処理装置)を載せた富岳を用いて「純国産」の生成AIをつくりだした。

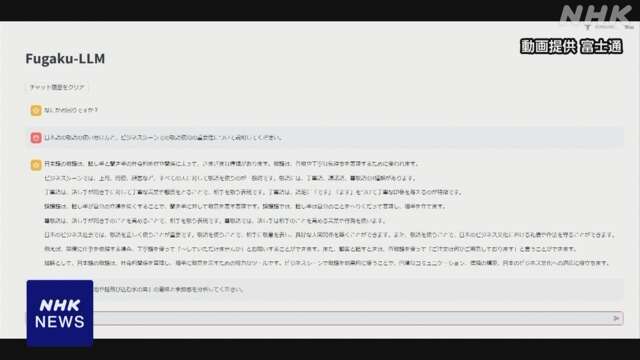

東北大学や名古屋大学、理化学研究所、サイバーエージェントなども参加し、生成AIの基盤となる大規模言語モデルを開発した。性能の指標となるパラメーターの数は130億で、独自のデータを学習させた。特に人文社会系の知識に強く、敬語など日本語の特徴を踏まえた自然な対話ができるという。

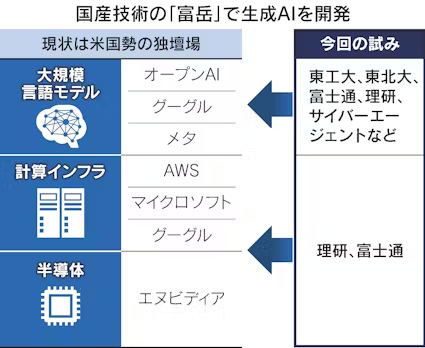

研究を主導した東工大の横田理央教授らによると、今回の研究では大規模言語モデルをつくることに加え、日本の企業や研究機関が持つ「国産技術」で生成AIを開発することに力点を置いたという。

大規模言語モデルにデータを学習させる際には、大量の並列処理を得意とする画像処理半導体(GPU)を搭載したスパコンが使われる。AI向けの半導体の世界市場ではエヌビディアが8割のシェアを持ち、1強体制を築いている。

AI開発企業の間ではGPUは奪い合いの状態で、価格は高騰している。資金力のある米テクノロジー大手が調達面で優位に立ち、AIの開発や運用に使う計算インフラの整備ではマイクロソフトやアマゾン・ウェブ・サービス(AWS)などが先行する。

日本にとって米企業と良好な関係を築くことは重要だが、過度に依存すれば経済安全保障上のリスクにもなりうる。生成AI分野で日本企業が本格的に巻き返すうえで、米企業に依存しない計算インフラを活用する必要性が高まっていた。

東工大などは今回、計算速度のランキングで世界一になった実績のある富岳に着目した。富士通のCPUをベースとしておりGPUは使っていないが、ソフトウエアの技術などを工夫し、並列処理の性能を高めた。大規模言語モデルに学習させる際の演算速度は従来の6倍に上がったという。

東工大の横田教授は富岳を活用した意義について「エヌビディア以外のプロセッサーを試す流れをつくれればよい」と話した。開発した大規模言語モデルや研究で得られた知見は広く公開し、生成AI分野における国産技術の振興につなげる。

【関連記事】

- ・理研、量子計算機・スパコン一体運用へ 富岳とも連携

- ・スパコン、富岳4位に後退 米国勢が世界トップ3独占

- ・「富岳」で生成AI、ChatGPTに対抗 NTTやサイバー参入

鄭重声明:本文の著作権は原作者に帰属します。記事の転載は情報の伝達のみを目的としており、投資の助言を構成するものではありません。もし侵害行為があれば、すぐにご連絡ください。修正または削除いたします。ありがとうございます。